링크: https://aclanthology.org/2021.naacl-main.185.pdfhttps://aclanthology.org/2021.naacl-main.185.pdf

배경

용어

- Priming: 지피티와 같은 사전학습 언어모델에게 특정 테스크나 스타일 컨텍스트를 유도하기 위해 초밥 입력을 설계하는 기법. Priming의 구체적인 방법이 fewshot-learning, Instruction tuning 등 있음

- Cloze type: Q. 빨간 과일은 뭐가 있어? A. 사과 의 구조가 아닌 Q. 빨간 과일은 뭐야? A. 정답은 사과 와 같은 일정한 구조

- Soft-label: ‘사과’와 같은 정확하게 분류된 라벨이 아닌 (사과 0.3, 오렌지 0.1, 포도 0.6)와 같이 확률로 나타낸 라벨값

GPT-3의 한계

- GPT-3와 같은 대형 언어 모델이 학습 (파라미터 업데이트) 없이 많은 테스크에서 높은 성능을 보였음

- 하지만 GPT-3의 few-shot 기능은 의도된게 아닌 많은 데이터를 학습시키면서 생긴 부수적인 능력임

- GPT-3는 많은 컴퓨팅 자원이 필요하며 탄소 발자국을 남김

- → 작은 모델도 few-shot learner로 쓸수는 없을까?

기술

PVP

- 패턴 P로 Task나 데이터를 close type question으로 변형하고, 버버라이저 V로 각 레이블을 모델 어휘에 있는 토큰 시퀀스로 변형하여 문제 해결

- 두 문장의 관계가 함의인지 아닌지 판별하기 위해

- GPT-3: <x1> <x2> 이 문장의 관계는? <label> 처럼 각 클래스 라벨 별로 확률을 구해 가장 높은 확률의 클래스를 선택함.

- PVP: <x2>? , <x1>. 라는 패턴 P를 만듬. 그리고 Vervelizer를 활용해 클래스를 Vocab에 있는 토큰 중으로 매핑함. 그리고 마스크 토큰 에 들어갈 토큰 별로 확률을 구함. 예를 들어 Yes 20% No 80% 가 나오면 다시 함수에 넣어 not_entailment로 매핑하여 라벨을 정함

Label data와 Unlabeled data

- Label data: 모델이 적절한 토큰을 예측하도록 Tuning

- Unlabeled data: ensemble로 토큰을 예측해서 다음 iPVP 모델을 학습하는데 사용

Multiple Mask

- Multiple Mask를 채우는 3가지 방법 max-first, ltr, parallel이 있는데 이 중 max-first가 가장 성능이 좋다고 함

- max-first는 확률이 높은것부터 채우고 다시 mask하여 맞추는 방법

- 이 논문에서 GPT-3는 left-to-right 모델이기 때문에 한계가 있다고 하였는데 Multiple Mask에서도 ltr이 성능이 가장 낮아 관련이 있어 보임

PET와 iPET

- 성능을 높이고 안정성을 위해 ensemble하면 PVPx3 만큼의 메모리를 사용해야함.

- 패턴과 버버라이저 (PVP)을 선택하고 32개의 labeled data (train과 test 분류) 로 [MASK] 토큰을 예측하며 학습

- 학습한 교사 모델 별로 (labeled data에 대한) 정확도 가중치를 반영하여 unlabeled data의 라벨의 확률을 예측하여 데이터셋 생성

- 학생 모델로 확률을 학습하도록 distillation하여 iPET 학습

실험

- ALBERT-xxLarge-v2 로 실험

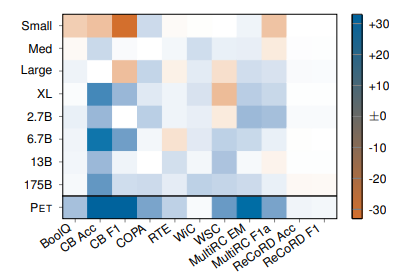

- SuperGLUE dataset에서 더 작은 모델을 아주 적은 파라미터만 튜닝하여 큰 모델인 GPT-3보다 높은 성능 달성

- 지피티의 fewshot example 개수와 같은 32개의 labeling 데이터로 튜닝

- 각 task 별로 3개의 Pattern을 만들어 실험함

- 논문의 저자는 ALBERT가 양방향 모델이라 GPT보다 높은 성능을 낼 수 있다고 함

- GPT-3의 경우 하나의 Pattern (마지막 토큰을 예측하여 클래스를 분류하는) 을 사용하였으나 ours는 task별로 다양한 Pattern을 사용하여 높은 성능을 낼 수 있었고, 둘을 섞은 comb가 가장 성능이 좋다고 함

결과 및 결론

- SuperGLUE에서 더 적은 파라미터와 적은 파라미터 튜닝으로 높은 성능 달성

- 세자릿수 적은 LM을 사용하여 superGLUE에서 GPT3와 유사한 text classification 성능을 보임

- 이는 비용을 절감할 뿐만 아니라 환경에 미치는 영향을 줄이고 탄소발자국을 줄일수 있음

- 향후 생성 LM과의 결합하면 흥미로울 것

강점

- 작은 모델로도 큰 모델과 같은 fews-hot learner 가능

약점

- Text classification task에 관해서만 사용 가능

- Tuning이 필요

잘못된 부분 있으면 알려주세요~

'논문 리뷰 > 자연어처리' 카테고리의 다른 글

| Parameter-Efficient Transfer Learning for NLP 리뷰 (0) | 2025.04.27 |

|---|---|

| ALBERT: A Lite BERT for Self-supervised Learning of Language Representations 리뷰 (0) | 2025.04.26 |

| RoBERTa: A Robustly Optimized BERT Pretraining Approach 리뷰 (0) | 2025.04.26 |